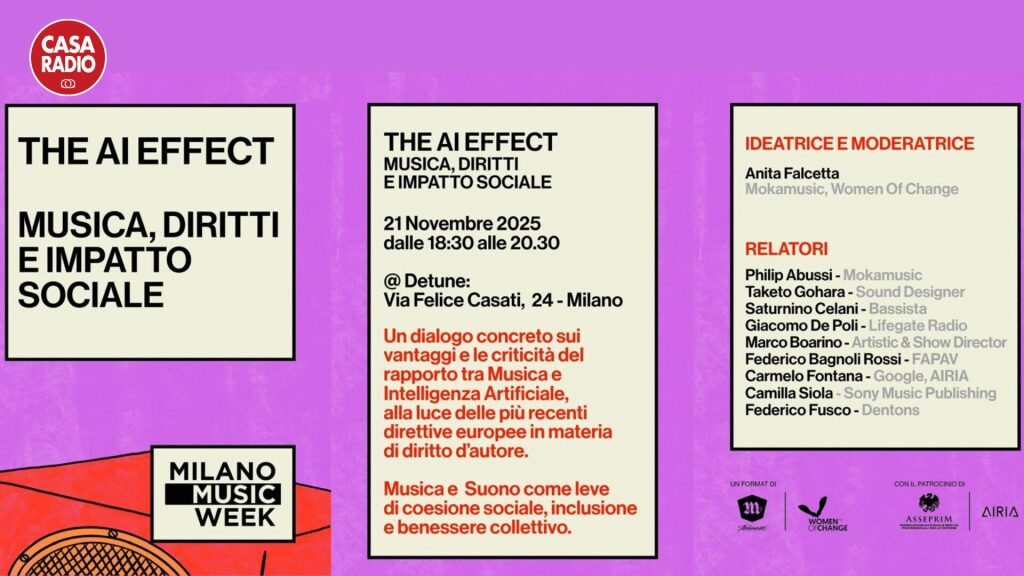

Al @Detune, locale simbolo della Milano musicale, in via Felice Casati. In occasione della Milano Music Week, va in onda “The AI Effect: musica, diritti e impatto sociale”, idee concrete, voci autentiche, pubblico protagonista, una public discussion che ambisce a fare un passo oltre il dibattito ideologico su intelligenza artificiale e creatività.

A firmare l’iniziativa sono Mokamusic, realtà attiva nella produzione e nei servizi musicali, e Women Of Change Italia, associazione impegnata nella promozione culturale e sociale. Il format è dichiaratamente ibrido: non un convegno tecnico per addetti ai lavori, ma un confronto aperto, in cui musicisti, produttori, giuristi, associazioni di categoria e pubblico provano a costruire un lessico comune per affrontare il rapporto tra AI e industria musicale.

A ideare e moderare l’incontro è Anita Falcetta, co-fondatrice di Mokamusic, presidente di Women Of Change Italia e divulgatrice culturale, in dialogo con un parterre che incrocia mondi normalmente separati: quello del palco e dello studio di registrazione, quello delle major e delle piattaforme, quello degli avvocati e delle nuove associazioni che si occupano di regolazione dell’intelligenza artificiale. Sfondo dell’evento è un settore, quello musicale, che sta vivendo una trasformazione accelerata: l’AI entra in studio, nei tool di composizione, nelle piattaforme di distribuzione, nella gestione dei cataloghi, nelle campagne di marketing. E riapre interrogativi fondamentali su cosa sia oggi un’opera musicale, chi ne detenga i diritti, come si debbano remunerare le filiere creative.

Dalla demo casalinga alla “resurrezione” in alta definizione: la lezione del caso Beatles

Per capire la portata del cambiamento basta guardare a uno degli episodi più discussi degli ultimi anni: il recupero e la pubblicazione di brani inediti a partire da vecchie demo, rese “ascoltabili” grazie a sofisticati sistemi di audio restoration basati su machine learning.

In quel caso, l’intelligenza artificiale non ha scritto una canzone al posto di un autore, ma ha letteralmente separato e ripulito tracce vocali e strumentali che altrimenti sarebbero rimaste imprigionate in un nastro di scarsa qualità. Il risultato è una nuova categoria di intervento: non più solo remaster o remix, ma una vera e propria “seconda vita” di materiali che appartengono al passato e che vengono proiettati nel presente con uno standard sonoro contemporaneo.

Per l’industria, si apre una gigantesca opportunità di valorizzazione dei cataloghi. Ma, insieme, si apre una zona grigia in cui la linea di confine tra restauro, reinterpretazione e manipolazione è sempre più sottile. Quando una demo viene completata decenni dopo con strumenti che l’autore non ha mai conosciuto, di chi è davvero l’opera finale? Quali consensi sono necessari? E quali diritti maturano sui nuovi elementi creativi e tecnologici che hanno reso possibile quella trasformazione?

È esattamente su questo crinale, tra potenziale economico e rischi di snaturamento, che si colloca “The AI Effect”: un tentativo di portare la riflessione sul terreno concreto di chi scrive, produce, pubblica musica ogni giorno.

Abussi: «L’AI è uno strumento, non un sostituto dell’artista»

Tra le voci protagoniste dell’appuntamento milanese c’è Philip Abussi, co-fondatore di Mokamusic, compositore, music supervisor e AI artist. La sua è una posizione tanto netta quanto sfumata: l’AI non è un nemico della creatività, ma un nuovo strumento nella cassetta degli attrezzi del musicista.

«Il processo creativo – è la sua chiave di lettura – resta lo stesso. Si può partire da una melodia, da un giro di accordi, da un beat o da un frammento di testo. La differenza è che oggi esistono strumenti, basati sull’intelligenza artificiale, capaci di esplorare in pochi secondi combinazioni timbriche, pattern ritmici, texture sonore che un tempo richiedevano giornate intere di sperimentazione.»

Il punto non è sostituire l’artista, ma potenziarne le possibilità. L’AI interviene in ogni fase della filiera: dalla generazione di idee alla pre-produzione, dal sound design al missaggio, fino alla post-produzione avanzata e al restauro di materiali d’archivio. In questo scenario, secondo Abussi, la vera discriminante è la responsabilità con cui questi strumenti vengono usati:

«Un conto è usare l’AI per estendere il proprio linguaggio artistico, altro conto è farne una scorciatoia per bypassare studio, ricerca e identità.»

Autotune, voci clonate e “idoli sintetici”: dove si ferma l’autenticità

L’intelligenza artificiale arriva in un settore che, di fatto, convive con la tecnologia da decenni. Prima dell’AI c’erano (e ci sono ancora) autotune, pitch corrector, plug-in di mastering automatico, strumenti che hanno già cambiato profondamente il modo di produrre e di percepire la musica. Oggi, però, si sta facendo un passo ulteriore. Non si tratta soltanto di correggere un’intonazione o di comprimere meglio una traccia. Si tratta di poter clonare la voce di un artista, generare nuove linee vocali con il suo timbro, creare performer virtuali “fotorealistici” che non esistono nella realtà, ma hanno canzoni, videoclip, fan base e persino contratti pubblicitari.

Nel dibattito emergono anche i casi di etichette discografiche nate per costruire progetti interamente AI-driven: volti “prestati” da influencer o creator e infrastrutture sonore, testuali e visive affidate a modelli generativi.

«È un modello che può funzionare a livello di prodotto – osserva Abussi – ma che rischia di impoverire il tessuto culturale, se diventa dominante. La musica non è solo output, è anche percorso, fatica, crescita. Se togliamo l’esperienza umana dalla filiera, rimane un oggetto sonoro perfetto ma privo di biografia.»

Resta il tema dell’emozione. Molti addetti ai lavori cresciuti con il rock d’autore fanno fatica a riconoscersi in voci pesantemente processate o completamente sintetiche. Ma le nuove generazioni vivono già dentro un’estetica diversa: ciò che conta è l’insieme di suono, immaginario visivo, narrazione sui social. La domanda, in questo caso, non è tanto se una voce sia naturale o artificiale, ma se riesce a creare un legame con chi ascolta.

La voce come identità: consenso e “immortalità digitale”

L’altro grande fronte è quello etico-giuridico. La voce, tanto più quando è riconoscibile, è parte dell’identità personale di un artista: clonarla, replicarla o manipolarla apre un fronte di responsabilità che va oltre il copyright tradizionale.

Nel confronto al Detune emerge una linea di principio chiara: nessuna clonazione senza consenso esplicito. Non basta il possesso dei diritti sul master o sul catalogo, occorre definire regole precise sull’uso dell’identità vocale, soprattutto quando l’AI consente di far cantare a un artista parole che non ha mai pronunciato o di farlo “tornare” dopo la morte.

È qui che entra in gioco la questione dell’“immortalità digitale”: la possibilità di poter continuare a produrre e monetizzare contenuti con la voce, l’immagine o la “persona” di un artista anche dopo la sua scomparsa fisica. Da un lato, è un modo per valorizzare cataloghi storici e mantenere viva la relazione con il pubblico. Dall’altro, rischia di trasformare l’artista in un brand infinito, gestito da algoritmi e contratti, con margini sottilissimi tra omaggio, sfruttamento e abuso.

Norme, contratti e collecting: il diritto d’autore alla prova dell’AI

Se la dimensione creativa è liquida, quella normativa lo è ancora di più. Il quadro regolatorio europeo e nazionale sull’intelligenza artificiale sta iniziando a delineare alcuni principi cardine: trasparenza sui dati di addestramento, centralità del controllo umano, tracciabilità dei contenuti generati.

Per la musica, questo significa innanzitutto fare chiarezza su tre piani:

-

Le opere create “con” l’AI, in cui l’autore umano utilizza strumenti intelligenti come supporto al proprio lavoro creativo.

-

Le opere create “da” sistemi generativi, con minima o nulla interferenza umana nella fase compositiva.

-

L’uso delle opere esistenti per addestrare i modelli, cioè il modo in cui cataloghi musicali, performance e registrazioni vengono trasformati in dataset.

Nel primo caso, la linea prevalente è riconoscere la piena tutela autorale, purché si possa dimostrare l’esistenza di un apporto creativo umano originale. Nel secondo, molte giurisdizioni tendono a negare la configurabilità di un diritto d’autore in senso classico, parlando semmai di diritti connessi sui risultati generati o di licenze contrattuali sui servizi. Nel terzo, la questione è più delicata: le società di collecting e le associazioni degli autori chiedono di poter negoziare condizioni e compensi per l’utilizzo delle opere come materia prima dei dataset, superando la logica di “presa in blocco” da parte delle big tech.

Sono temi che chiamano in causa i protagonisti istituzionali presenti al talk: dalle associazioni che difendono l’industria dei contenuti audiovisivi e musicali, agli studi legali specializzati in proprietà intellettuale, fino ai giuristi che siedono nei tavoli dedicati alla regolazione dell’AI.

Un parterre che incrocia palco, studio e tribunale

La forza di “The AI Effect” sta proprio nella composizione del panel. In platea e sul palco si incontrano produttori e sound designer, musicisti, direttori artistici, responsabili di radio e piattaforme, avvocati, in-house counsel di grandi gruppi tecnologici e discografici.

La presenza di figure abituate a maneggiare quotidianamente i linguaggi del pop, del rock, dell’elettronica e del cinema si intreccia al punto di vista di chi, nei contratti, scrive clausole su licenze, sincronizzazioni, sfruttamento secondario, diritti morali e patrimoniali. Il dialogo non è sempre semplice, ma è proprio qui che si gioca la partita: tradurre in regole comprensibili i processi opachi dell’AI, rendere negoziabile ciò che oggi è spesso nascosto nei “black box” degli algoritmi.

Il pubblico come “terzo attore” della filiera

C’è poi un soggetto spesso dimenticato nel dibattito su AI e musica: il pubblico. La forza dell’iniziativa milanese è anche quella di coinvolgere gli ascoltatori come parte attiva, non solo come destinatari finali di prodotti finiti.

Educare il pubblico a porsi domande – come è stata realizzata questa canzone, che rapporto c’è tra l’artista e la tecnologia, quali diritti vengono riconosciuti a chi ha creato le opere su cui l’AI si è addestrata – diventa un pezzo importante della strategia di sostenibilità del settore. Se l’AI prende posto in studio, serve una nuova alfabetizzazione dell’ascolto, che aiuti a distinguere tra manipolazioni ingannevoli e sperimentazioni legittime, tra clonazioni abusive e progetti dichiarati come “AI-based”.

Per le realtà che organizzano il talk, la musica non è solo intrattenimento, ma anche strumento di coesione sociale, inclusione, comunicazione di valori. In questo senso, l’AI può essere un alleato formidabile – per esempio ampliando l’accessibilità, riducendo i costi di produzione per i piccoli, dando voce a chi non ha una formazione accademica – oppure un moltiplicatore di disuguaglianze, se concentrata nelle mani di pochi player globali.

Verso un nuovo patto tra creatività, tecnologia e diritti

Il messaggio che esce dal Detune è chiaro: la questione non è scegliere tra un futuro “con” o “senza” intelligenza artificiale, ma decidere come integrarla in modo sostenibile nella filiera musicale.

Per riuscirci, serve un nuovo patto tra creatività, tecnologia e diritti. Un patto che riconosca la centralità dell’artista e del suo apporto umano, tuteli la voce e l’identità di chi crea, garantisca trasparenza sui processi di generazione dei contenuti, definisca regole eque per l’uso dei cataloghi come materia prima dei dataset, apra spazi di sperimentazione per progetti che dichiarano fin dall’inizio la propria natura ibrida o sintetica.

“The AI Effect” prova a fare quello che spesso la cronaca non riesce a fare: fermare il flusso indistinto di entusiasmi e paure e prendere sul serio, in un’unica stanza, tutte le parti in gioco. La musica, ancora una volta, si conferma laboratorio anticipatore dei cambiamenti che investono l’intera economia dei contenuti. Ed è proprio da qui, da un palco milanese durante una settimana dedicata alla musica, che può partire una riflessione più ampia sulla convivenza tra algoritmo e creatività umana nell’industria culturale del prossimo decennio.